Вопрос: что может вызвать большее обсуждение в интернете, чем появление Тома Круза в TikTok? Ответ: появление в TikTok фейкового Тома Круза, созданного с помощью нейросети. Всего за несколько дней аккаунт с тремя короткими видео, в которых «Том Круз» играет в гольф, показывает фокусы и рассказывает о встрече с Горбачевым (!), набрал миллионы просмотров и был упомянут в десятках изданий. Все потому, что Круз там не настоящий, а созданный с помощью технологии Deepfake.

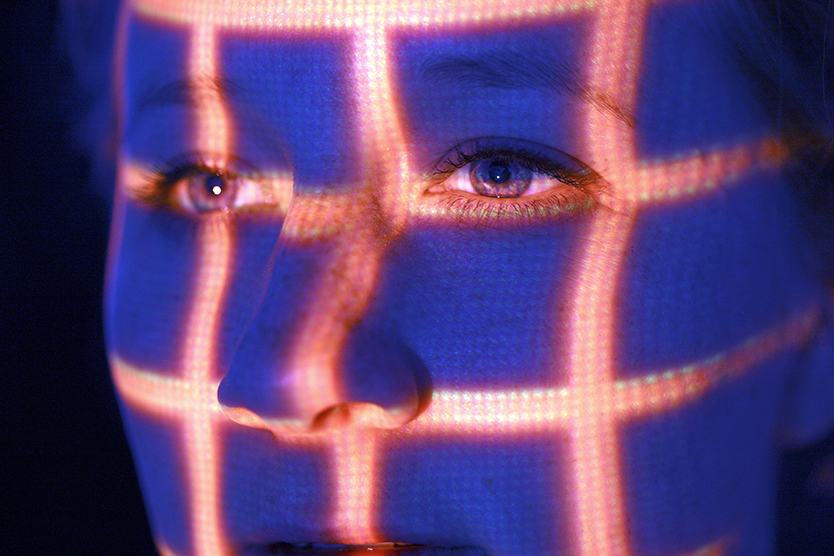

Дипфейки – смесь терминов deep learning (глубокое обучение) и fake (фальшивка) — относительно новая технология, позволяющая с помощью нейросети создавать относительно правдоподобные имитации людей на видео. Можно, в частности, наложить лицо одного человека на тело другого и синхронизировать движение губ с любым текстом — так, например, режиссер Джордан Пил еще в 2018 году выпустил видео с Бараком Обамой, называющим Дональда Трампа нехорошими словами. Ролик был создан, чтобы предупредить аудиторию об опасности fake news, и дипфейков в частности. Дипфейки в целом упоминаются в СМИ преимущественно в контексте различных тревог, опасений и страхов. Вопрос в том, насколько они оправданны.

Народная мудрость гласит, что интернет на 99% состоит из порно и котиков. Народная мудрость, как это часто бывает, заблуждается. Если проанализировать миллион самых просматриваемых в сети сайтов, на порнографию из них придется только 4%. По другим оценкам — не более процента. Дипфейки, с другой стороны, буквально на 96% сводятся к порнографии. 99% таких дипфейков — это наложение лиц популярных актрис (теоретически актеров тоже, но давайте не будем лукавить) на тела порнозвезд. Технология начала активно распространяться в 2017 году, и уже в 2018-м популярная соцсеть Reddit запретила все сообщества, связанные с такого рода порнофейками, а сами материалы пропали с Pornhub и других крупных порносайтов, работающих в рамках правового поля. Более-менее находящиеся на свету части интернета такие материалы выдавливают — в 2019 году «раздевающее» женщин приложение DeepNude было удалено отовсюду в течение буквально часов после запуска, а его копии запрещены к распространению на популярном ИТ-хостинге GitHub.

При этом в большинстве стран законы пока не могут угнаться за технологией. В США и ряде стран Запада в последние годы едва-едва запретили так называемую «порноместь» — когда реальные фото и видео сексуального характера размещают в сети без разрешения фигуранта записи. Чье тело – того и права, рассуждает закон. А вот если тело на видео принадлежит кому-то, кто согласился на съемки и распространение за деньги и речь идет только о компьютерном наложении чужого лица, в глазах закона обладатель лица жертвой преступления не является. В крайнем случае есть перспектива гражданского иска по нарушению авторских прав на изображение лица, но правоприменительная практика здесь до сих пор слабая. При этом прогресс есть — в 2019 году «дипфейки» и «дипнюдсы» запретили в американском штате Вирджиния, аналогичный закон разрабатывается в Великобритании. Законодательный запрет порнографических дипфейков, разумеется, не приведет к их исчезновению — интернет полон темных уголков, где законы не действуют. Но эти запреты могут стать основой для дальнейшего регулирования дипфейков, которое может понадобиться уже очень скоро.

Реальность такова, что для большинства пишущих законы людей риск того, что кто-то захочет сварганить порно с их участием, достаточно мал.

И это многое объясняет о темпах законодательного решения подобных проблем. Но все эти люди участвуют в выборах. И вот мы подходим к главному страху относительно дипфейков, который будоражит умы редакций СМИ и зданий министерств и парламентов — ну или взбудоражит, как только в последних разберутся, что вообще такое дипфейки. А что если кто-то сделает фейковое видео с политиком, например, боксирующим с младенцем? Технология дипфейков это, безусловно, позволяет. Но возникает контрвопрос: а зачем?

У пресловутого fake news есть много свойств, и главное среди них — простота. В производстве, распространении и усвоении. Зачем делать технологически сложный и затратный дипфейк, если можно слегка замедлить реальное видео и создать иллюзию, что человек пьян? Или с помощью простого монтажа выставить, скажем, кандидата в президенты Джо Байдена засыпающим во время интервью немощным стариком? А можно и не монтировать ничего, а собрать и растиражировать абсолютно реальные примеры того, как тот же Байден путает выборы в Сенат с президентскими, а Украину — с Афганистаном. Любую цитату можно вырвать из контекста, налепить на несимпатичное фото и превратить в мем. На худой конец, даже самый опытный политик с удовольствием скажет любую ерунду обаятельному пранкеру. И, опять же, это будут настоящие слова.

Дипфейки же, как и любой другой откровенный фейк, легко разоблачить. Даже «пугающе реалистичные» тиктоки с «Томом Крузом» можно распознать как фальшивые невооруженным взглядом. Замедлите приведенное выше видео до 0,25 и посмотрите внимательно на 43–44-й секундах. Видите, как темные очки на мгновение пропадают, оказавшись на уровне челюсти Круза? Именно там и наложена основная маска дипфейка. Это не говоря о сложностях в имитации голоса и манер — здесь нейросеть не поможет, нужен профессиональный двойник, как в случае с «Крузом». К тому же полагаться на голый глаз и не нужно — ИТ-гиганты активно разрабатывают инструменты для выявления дипфейков с помощью все тех же нейросетей. А теперь сравните две линии защиты: «Ой, я такого не говорил, ну то есть говорил, но не совсем так, в другом контексте, и не про тех, и вообще, я знал, что это пранкер и просто ему подыгрывал» и «Это не я, эти слова никогда не были мной сказаны, это высокотехнологичная, дорогая и сложная подделка, специально заказанная моими врагами, и я могу это доказать». На последней фразе можно и в Белый дом въехать, если грамотно сработать.

Значит ли это, что дипфейки — безвредное явление? Необязательно. Да, дипфейки на данном этапе развития технологии не могут быть использованы для того, чтобы реально кого-то обманывать — по крайней мере, обманывать всерьез и надолго. Сама идея дипфейка вредит дискурсу намного ощутимее, и не просто так тревогу по поводу них бьют в первую очередь СМИ. В мире «постправды», чтобы это ни значило, каждый хочет сказать:

«Вы не можете верить своим глазам. Вы не можете верить своим ушам. Вы можете верить только мне. И списку одобренных мной изданий».

Но, возможно, главная потенциальная опасность технологии дипфейков кроется в наиболее невинных потенциальных применениях. Компания Nvidia в 2020 году презентовала ИИ-платформу Maxine, которая использует аналогичную технологию для расширения функционала голосовых чатов. Например, для создания дипфейк-маски собственного лица во время разговора по условному Zoom, которая будет смотреть в камеру — то есть в глаза собеседнику, — в то время как человек на самом деле смотрит в экран. А заодно маску можно и приукрасить. Зачем бриться-мыться-краситься для рабочих переговоров, если дипфейк услужливо спроецирует на экран вас, настоящего и в реальном времени, но ухоженного и в выглаженной рубашке?

Социальные сети уже подталкивают большинство людей к конструированию красивого, но в той или иной степени фальшивого образа для демонстрации внешнему миру. Приход дипфейка в мейнстрим как инструмента для создания постоянного идеализированного аватара кажется логичным продолжением этого тренда. Один из вариантов конечной точки этого пути еще в 2009-м предложил режиссер Джонатан Мостоу в фильме «Суррогаты». Там в недалеком будущем большинство людей предпочитают не выходить из дома, а вместо этого пользуются вечно красивыми и здоровыми человекоподобными роботами-суррогатами.

С нами такого, конечно, не случится. Зачем придумывать и строить сложных роботов, если можно просто все перенести в мир виртуальных образов? У каждого идеального дипфейк-аватара будет идеальная красивая жизнь в Instagram и подправленные нейросетью глубокомысленные размышления в Facebook. Причем смерть оригинала ведению страничек не помешает — Microsoft уже над этим работает, там же тоже смотрят «Черное зеркало». Не надо бояться, что дипфейки нас обманут, — они просто нас заменят.